Impresionante documental sobre la inteligencia artificial capaz de aprender en vez de procesar. Además el guión del documental es muy bello y sensible aunque no estés muy familiarizado con los avances tecnológicos o la informática.

Explicar la noticia de hace unos pocos días sobre AlphaGo Zero, el último avance en el algoritmo que fue capaz de ganar con gran ventaja a los tres mejores jugadores del mundo de Go, el llamado “ajedrez asiático”, con unas reglas aparentemente muy sencillas pero con posibilidades combinatorias enormemente complicadas, puede ser relativamente complicado en el mundo occidental, donde la popularidad de este juego es relativamente escasa.

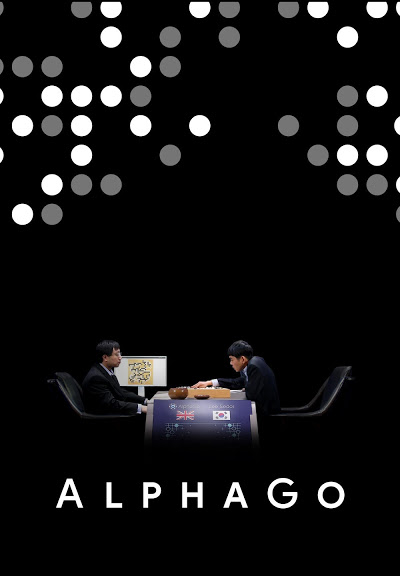

Lo que AlphaGo obtuvo cuando venció a los mejores jugadores del mundo fue un desarrollo de deep learning seguido de reinforcement learning: tras entrenar originalmente al algoritmo con todas las partidas de Go registradas en la historia del juego disponibles, se obtuvo una máquina capaz de imitar a los mejores jugadores, capaz de predecir sus jugadas en un 57% de las ocasiones, pero incapaz, por lo general, de mejorar su rendimiento en una partida. Para lograrlo, se planteó entrenar a esa máquina con nuevas partidas inventadas por sí misma mediante combinatoria, dando lugar a jugadas previamente inexistentes, no llevadas a cabo anteriormente, con probabilidades muy bajas y no contempladas nunca – y por tanto, no anticipables – por jugadores humanos, pero que fueron las que, en último término, lograron decidir algunas de las partidas definitivas. AlphaGo logró ganar a los mejores jugadores humanos gracias a haber probado anteriormente espacios combinatorios que, sencillamente, nunca habían sido probados anteriormente en ninguna partida, y que podían, a pesar de su bajísima probabilidad, dar lugar a estrategias ganadoras.

¿Qué aporta, sobre esto, AlphaGo Zero? Sencillamente, eliminar la primera fase, la del aporte del registro histórico de partidas de Go jugadas por humanos. Para obtener este nuevo algoritmo, que ha sido capaz de vencer al anterior AlphaGo por cien partidas a cero, se partió, como su nombre indica, desde cero. Un algoritmo con las reglas del juego definidas, que comienza desde ahí a probar movimientos en partidas que juega contra sí mismo.

Tras el adecuado número de iteraciones, muchos millones de partidas, ese algoritmo, que nunca ha recibido información sobre partidas jugadas con humanos, supera al anterior, lo que elimina la necesidad, en problemas que puedan ser homologados a este – problemas estables con entornos altamente predecibles – de partir de una amplia cantidad de datos históricos

El AlphaGo original fue entrenado a partir de un aprendizaje supervisado, a partir de millones de movimientos de partidas disputadas por jugadores humanos expertos, y se sometió después a un proceso de refuerzo con juegos contra sí mismo.

El reto de los ingenieros en la nueva versión del algoritmo era lograr que aprendiera el juego partiendo de una “tabula rasa” y sin ningún conocimiento de partidas humanas previas.

AlphaGo Zero ha adquirido su maestría en el juego de estrategia únicamente disputando partidas contra sí mismo.

En tan solo unos días de autoaprendizaje, en los que el sistema jugó cerca de cinco millones de partidas contra sí mismo, AlphaGo Zero ya era capaz de superar a cualquier humano y derrotar a todas las versiones anteriores de AlphaGo.

Los autores del trabajo, ingenieros de la compañía británica DeepMind -adquirida por Google en 2014-, subrayan que su programa de inteligencia artificial ha descubierto de forma independiente algunos conceptos del juego del Go que los humanos tardaron siglos en conceptualizar.

VER DOCUMENTAL.

este documental está sujeto a un enlace que puede no estar activo en un futuro